Chatbots sind ein heisses Thema, wir haben bereits darüber berichtet. Mit einer Facette davon beschäftigt sich die aktuelle Ausgabe des CACM (Communications of the ACM): The Rise of Social Bots.

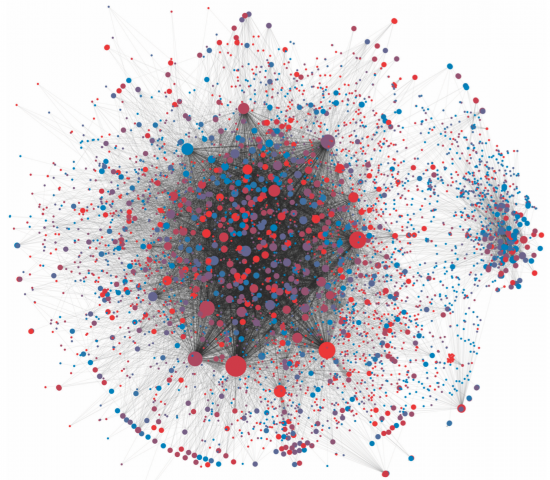

Kern der Frage sind “Fake Profiles” auf Sozialen Netzwerken. Sie dienen dazu, Information zu verbreiten und damit Meinung zu machen. Ein einfaches Beispiel ist der Aktienkurs der kleinen, bedeutungslosen Firma Cynk, der über Social Media zu einem Marktwert von 5 Mia. Dollar hochgejubelt wurde. Und danach komplett abstürzte. Schuld daran: Social Bots. Dasselbe Szenario ist für viele Situationen denkbar. Ein weiteres Beispiel im Artikel sind Wahlen in Kalifornien zum umstrittenen Thema gesetzlich vorgeschriebener Impfungen. Stimmt die Analyse der Indiana University, so stammt die Hälfte der “Diskussion” (die roten Punkte”) von Social Bots.

Wie erkennt man also ein Fake Profile? Über die Jahre wurden verschiedenen automatisierte Ansätze wie Sybilinfer [pdf], Sybillimit oder Sybilguard getestet aber keiner war leistungsfähig. Hauptgrund war, dass diese sich vor allem auf den Social Graph abstützen und mit der Hypothese arbeiten, dass echte User sich nicht mit Fake Accounts befreunden. Das tun sie aber leider.

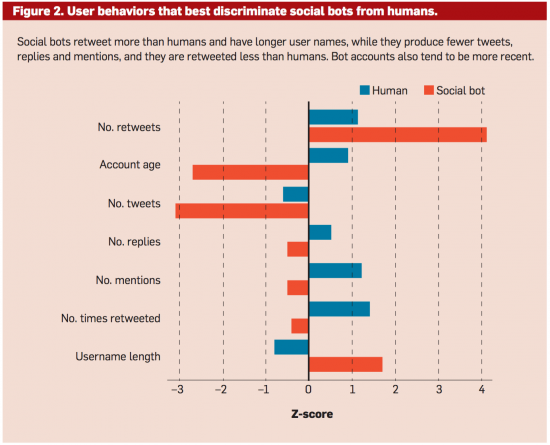

Weitere Analysemöglichkeiten sind die Hypothesen, dass sich Fake Accounts untereinander stärker verlinken, jünger sind als echte User, sich konsistenter Verhalten im Bezug auf zeitliche und inhaltliche Aktivität, eingeschränkte Sprachfähigkeit besitzen etc. Wie so häufig ist es aber ein Katz und Maus-Spiel und die Social Bots weichen immer gewiefter aus. Inbesondere wird menschliche Leistung und solche von Bots gemischt.

Die False Positve Rate war in allen Fällen fast 0 (die Studie liess dasselbe Profil mehrfach bewerten und das Ergebnis über >50% der Stimmen ermittelt). So hatten aber Motivation der Tester und Länge des Tests einen signifikanten Einfluss auf das Ergebnis… wir gesagt, ein sehr lesenswerter Artikel.

Eine Frage wurde mir nicht beantwortet: Wie viele Fake Profiles es gibt. Einziger Hinweise ist eine Aussage von Facebook aus dem Jahr 2011: 83 Millionen. Gefühlt sind es aber viel mehr.

Und hier noch der Teaser von CACM

The Rise of Social Bots from CACM on Vimeo.

PS: Der Artikel im CACM ist nicht öffentlich, doch wer mir eine Mail schickt…